ИИ-агент для поддержки клиентов

Для крупной металлургической компании мы внедрили универсального AI-агента, который работает поверх сервис-деска и базы знаний, понимает запросы пользователей и либо находит ответ в документации, либо направляет обращение в нужную команду. Решение автоматизировало типовые обращения, ускорило первые ответы и снизило нагрузку на экспертов поддержки.

О проекте

Крупная металлургическая компания с корпоративной системой, в которой множество ролей и сложная предметная область. Её поддержкой занимаются несколько команд: им приходится разбираться в большом объёме документации и постоянно решать нетривиальные кейсы.

Подходит для:

e-commerce / корпоративных порталов / SaaS-сервисов / онлайн-банкинга и финтеха / телекома / маркетплейсов услуг / сервис-десков крупных компаний / EdTech / медтех- и insurtech-сервисов / госуслуг и других сложных B2B-решений с многоуровневой поддержкой

Возможности

-

Интеллектуальная обработка сложных запросов поддержки

Понимание формулировок пользователя, определение уровня сложности, подбор ответа из документации и базы знаний без участия оператора там, где это безопасно.

-

Семантический поиск по базе знаний и документации

Поиск релевантных инструкций и регламентов при «живых» запросах, без точных ключевых слов и знания структуры портала.

-

Интеллектуальная маршрутизация обращений

Автоматическая классификация инцидентов и запросов и отправка их сразу в нужную команду или очередь, сокращение числа пересылок между линиями поддержки и времени решения

-

Поддержка модерации и качества карточек/объектов

Проверка полноты и корректности заполнения полей, подсказки по недостающим атрибутам, снижение доли ошибок, неполных карточек и возвратов на доработку.

-

Разгрузка экспертов и ускорение онбординга

Перехват типовых и повторяющихся запросов AI-агентом, помощь новичкам через готовые ответы и подборку материалов по кейсу.

-

Автоматическое пополнение и актуализация базы знаний

Рост точности и полноты ответов без ручного переписывания инструкций за счёт успешных решений.

-

Сквозная аналитика по работе поддержки

Статистика по тематикам запросов, скорости обработки, доле автоответов и эскалаций, выявление узких мест процессов для дальнейшей оптимизации.

Цель

Автоматизировать поддержку клиентов компании с учётом глубокой оргструктуры, сложной документации и необходимости точной маршрутизации.

Задачи

- Анализ и архитектура

Провести аудит текущей поддержки и источников знаний, сформировать требования и спроектировать архитектуру AI-агента: контур LLM, семантический поиск, интеграции с сервис-деском, порталом, SSO и правами доступа. - Подготовка данных и моделей

Собрать и очистить документацию и исторические тикеты, разметить выборки; развернуть векторный поиск (эмбеддинги, индекс), обучить модели интентов/классификации/маршрутизации и настроить RAG-пайплайн для ответов. - Разработка и интеграция сервиса AI-агента

Реализовать backend-оркестратор и коннекторы к ITSM/порталам, встроить агента в интерфейс операторов и пользователей, настроить логику: автоответ, маршрутизация, эскалация на экспертов. - Качество, дообучение и безопасность

Настроить контур валидации ответов экспертами, сбор фидбэка и дообучение моделей; автоматическое пополнение базы знаний; внедрить контроль доступа к данным, аудит действий агента и требования по инфобезопасности. - Мониторинг и аналитика

Ввести технический мониторинг компонентов и метрики работы поддержки/агента (доля автоответов, эскалаций, SLA), настроить дашборды и отчётность для дальнейшей оптимизации процессов.

Что сделали

Мы развернули универсального AI-агента 2-го уровня, который работает поверх существующей инфраструктуры поддержки и базы знаний металлургической компании.

AI-агент:

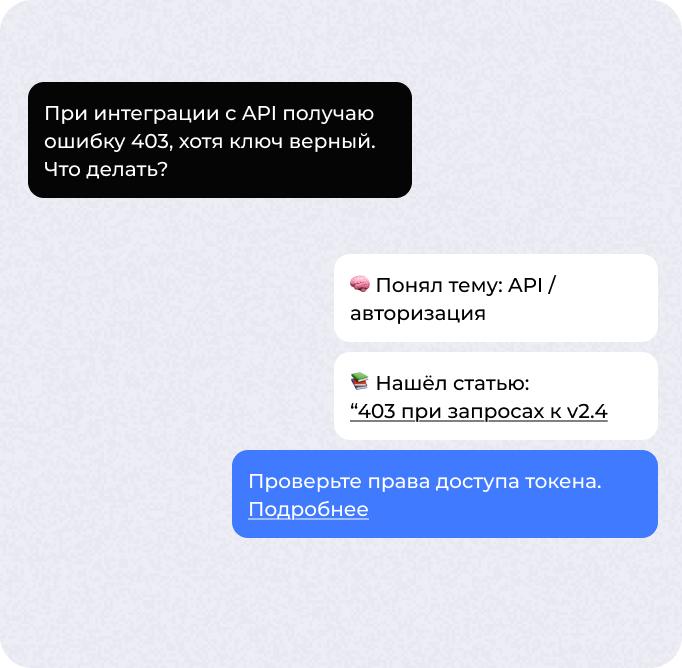

● Понимает тематику и сложность запроса. Из текста обращения определяет, о каком модуле, сценарии или типе задачи идёт речь, и оценивает, можно ли решить её автоматически.

● Ищет ответ в документации и базе знаний. Использует LLM/семантический поиск, чтобы быстро находить релевантные статьи, инструкции, регламенты и прошлые решения.

● Отвечает пользователю автоматически, если находит однозначный и проверенный ответ в базе знаний.

● Классифицирует и маршрутизирует сложные кейсы: определяет тип обращения и отправляет его сразу в нужную рабочую группу, минуя лишние пересылки.

● Эскалирует нестандартные ситуации: помечает кейсы, где требуется участие эксперта, и передаёт их на 2-ю линию вместе с подборкой релевантных материалов.

● Дообучается на новых шагах решения — успешные кейсы и обновлённые статьи автоматически расширяют базу знаний и повышают качество следующих ответов.

Этапы проекта

#1 Обследование и проектирование

-

Собрали требования бизнеса и службы поддержки, проанализировали текущие процессы и базу знаний, сформировали целевые сценарии работы AI-агента и спроектировали архитектуру решения: LLM-контур, векторный поиск, интеграции с ITSM, порталом и SSO.

#2 Подготовка данных и ML-основания

-

Выгрузили и очистили документацию и тикеты, разметили выборки, настроили пайплайн индексации (chunking, эмбеддинги, метаданные) и векторного поиска, а также провели первичное обучение и настройку моделей интентов, классификации и маршрутизации.

#3 Разработка ядра AI-агента и интеграций

-

Реализовали backend-оркестратор (связка LLM, векторного индекса и бизнес-правил), разработали коннекторы к сервис-деску и порталам, внедрили логику автоответов, маршрутизации и эскалации в реальный поток обработки обращений.

#4 Пилот и донастройка качества

-

Запустили пилот на ограниченном периметре (отдельные очереди и подсистемы), подключили экспертов для валидации ответов и сбора фидбэка, откалибровали пороги уверенности, дообучили модели и настроили пополнение базы знаний по результатам пилота.

#5 Промышленный запуск, безопасность и масштабирование

-

Расширили покрытие на дополнительные очереди и роли, внедрили все требования по инфобезу и аудиту, настроили мониторинг и дашборды, оптимизировали производительность и стоимость, а также утвердили регламент регулярного дообучения и обновления индексов.

Результаты и аналитика

| МЕТРИКИ | БЫЛО | СТАЛО |

|---|---|---|

| Время до первого ответа | 1-2 часа | <2 мин |

| Запросы, решённые на 1-м уровне | 20-30% | 60-80% |

| Время эскалации на 2-й уровень | 4 часа | <1 часа |

| Повторные обращения | 18% | <9% |

Stack

| Слой / Компонент | Инструменты и сервисы |

|---|---|

| Логика LLM-приложения и RAG |

OSMI AI (оркестрация промптов, RAG-пайплайны, A/B-тесты, логирование)

|

| LLM-модель |

Внутренняя модель Qwen 2.5 32B

|

| Семантический поиск и индексы |

Векторное хранилище (например, Qdrant)

эмбеддинги на базе внутренних моделей

|

| Интеграционная шина и интеграции |

Python (FastAPI/asyncio)

HTTP/REST

gRPC

коннекторы к ITSM/порталу

|

| Очереди и фоновые задачи |

Redis + BullMQ

|

| Хранилище данных и базы знаний |

Реляционная БД (например, PostgreSQL)

файловое/S3-хранилище

|

| Backend-сервисы и API-шлюз |

Python (микросервисы)

возможен API-шлюз (NGINX/Kong/Traefik)

|

| Инфраструктура и деплой |

Docker

Kubernetes (k8s)

Helm/CI/CD (GitLab CI/GitHub Actions)

|

| Мониторинг и логирование |

Prometheus

Grafana

централизованный логинг (ELK/EFK или аналог) + логи в OSMI AI

|

| Безопасность и доступ |

SSO (OIDC/SAML)

RBAC

TLS

vault-сервис для секретов

|

Со стороны OSMI IT проект вели

МШ

Михаил Шрайбман

CEO OSMI IT

фасилитировал взаимодействие и проектную логику

ДН

Денис Нагаев

CTO OSMI IT

обеспечивал, контролировал технические и архитектурные решения и реализацию

ДМ

Дмитрий Морковкин

Менеджмент проекта

МН

Максим Немов

DevOps, back-end разработка и LLM-инжиниринг

ВК

Владислав Кольца

Data-аналитика